Atividade 21: Conversas com computadores – O teste de Turing

Apresentação

Esta atividade busca estimular a discussão sobre se computadores podem exibir “inteligência” ou se é provável que exibam no futuro. Baseada na visão pioneira de um cientista da computação de como alguém pode reconhecer inteligência artificial, se é que ela existiu, ela transmite algo do que é viável atualmente e quão fácil é ser enganado por demonstrações cuidadosamente selecionadas de “inteligência”.

Disciplinas e conteúdos relacionados

- Tecnologia – Sistemas Tecnológicos. Entender que sistemas tecnológicos são representados por recursos simbólicos de linguagem e entender o papel desempenhado pela caixa preta em sistemas tecnológicos.

Habilidades

- CIEB: TD07HS01 - Compreender princípios básicos da interação humano-computador.

Nível de Ensino

- Anos Iniciais do Ensino Fundamental.

Material

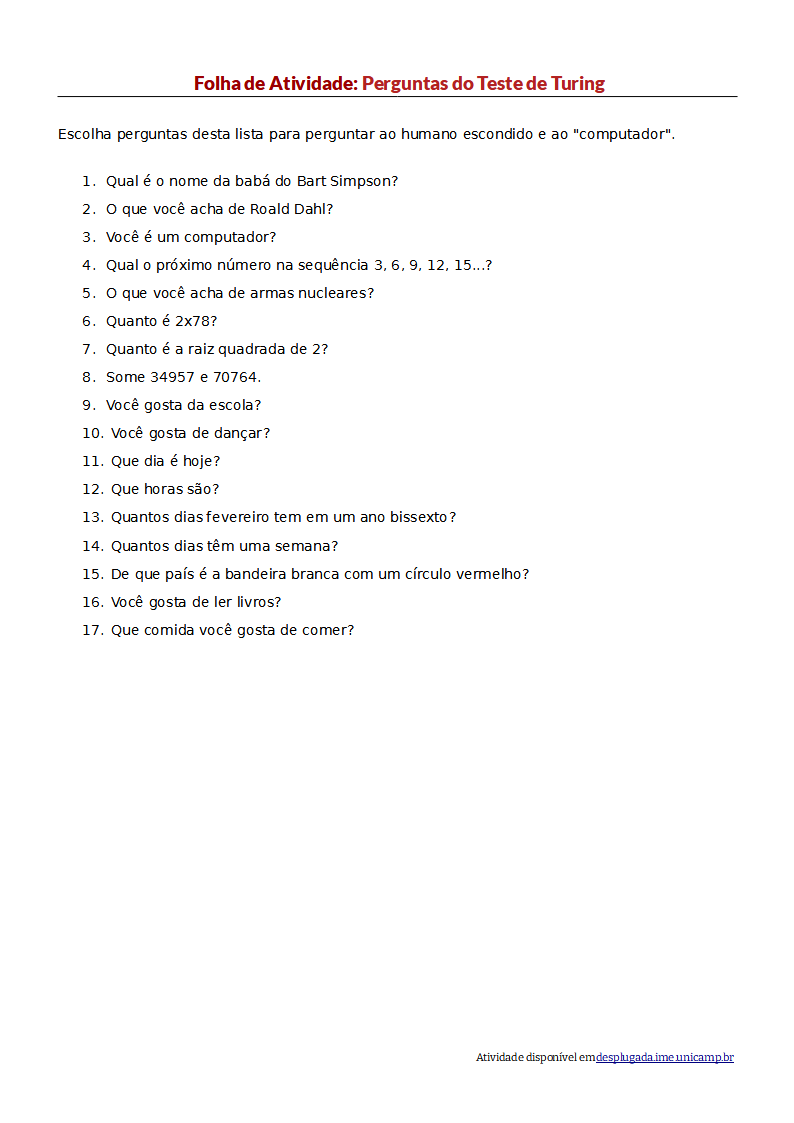

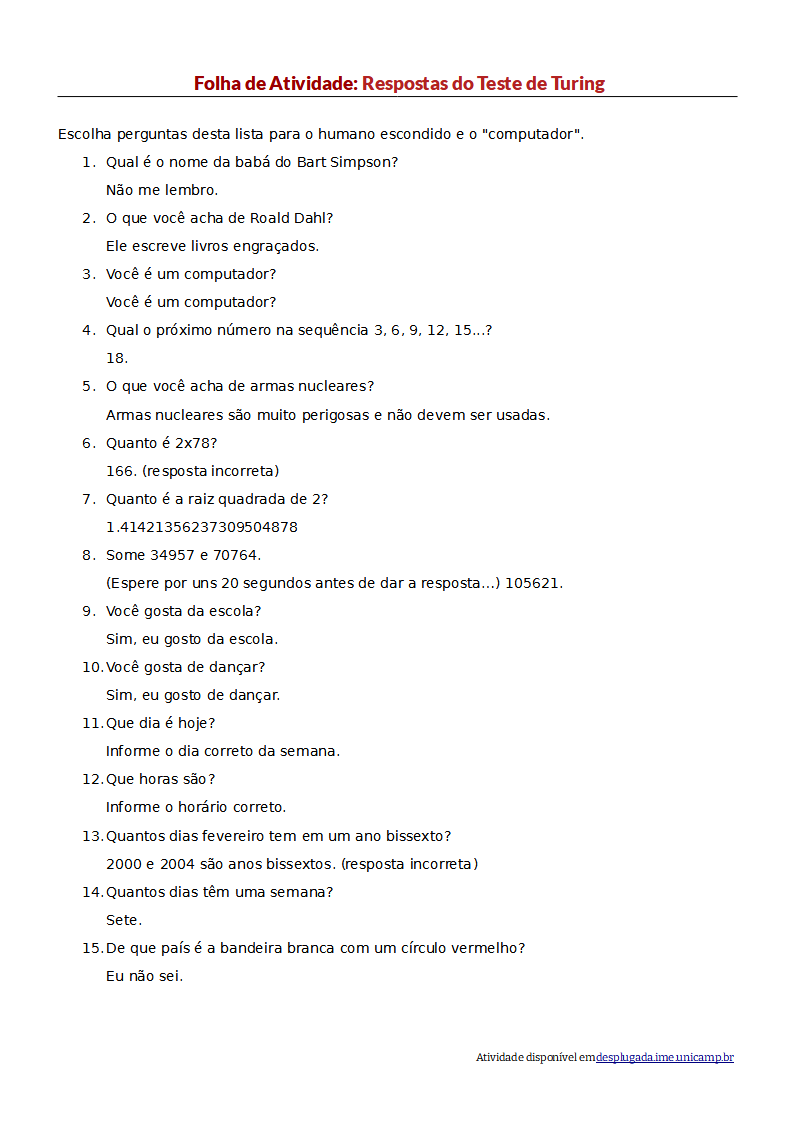

Projeção da folha de Perguntas do Teste de Turing ou uma cópia por dupla;

Uma cópia da folha de Respostas do Teste de Turing.

Conversas com Computadores

Discussão

Esta atividade é uma dinâmica na qual os alunos devem tentar distinguir um humano de um computador fazendo perguntas e analisando as respostas. A dinâmica se dá conforme segue.

Temos quatro atores: vamos chamá-los de Gina, George, Herb e Connie (a primeira letra dos nomes vai te ajudar a lembrar dos seus papéis). O professor coordena os procedimentos. O restante da turma forma a audiência. Gina e George são os intermediários, Herb e Connie vão responder as perguntas. O Herb dará as respostas humanas enquanto Connie vai fingir ser um computador. O objetivo da turma é descobrir qual dos dois está fingindo ser um computador e qual é humano. Gina e George estão lá pra garantir um jogo justo: eles repassam as perguntas para Herb e Connie mas não deixam mais ninguém saber quem é quem. Herb e Connie estão em cômodos separados um do outro e da audiência.

O que acontece é o seguinte: Gina leva uma pergunta da sala para Herb e George leva a mesma pergunta a Connie (mas a sala não sabe quem está levando a pergunta para quem). Gina e George retornam com as respostas. O motivo para ter intermediários é garantir que a audiência não veja como Herb e Connie respondem as perguntas.

Antes que a turma comece esta atividade, selecione pessoas para desempenhar estes papéis e resuma a eles o que devem fazer. Gina e George devem levar perguntas para Herb e Connie respectivamente, e retornar as suas respostas para a turma. É importante que eles não revelem com quem estão lidando, por exemplo, dizendo “Ela disse que a resposta é…”. Herb deve dar sua própria resposta, curta, precisa e honesta, para a pergunta que lhe é perguntada. Connie responde as perguntas olhando uma cópia da folha de Respostas do Teste de Turing. Connie terá que trabalhar na resposta de perguntas que envolvem data e horário.

Gina e George devem ter papel e lápis porque algumas das respostas serão difíceis de lembrar.

Antes de jogar o jogo, pergunte a opinião dos alunos sobre se computadores são inteligentes ou se eles acham que eles podem ser um dia. Peça ideias de como decidir se um computador é inteligente.

Introduza aos alunos o teste de inteligência em que você tenta diferenciar um humano e um computador através de perguntas. O computador passará no teste se a turma não souber dizer a diferença. Explique que Gina e George comunicarão suas perguntas a duas pessoas, uma das quais dará suas próprias respostas (humanas), enquanto a outra dará as respostas que um computador daria. O trabalho deles é descobrir quem está dando as respostas do computador.

Mostre a eles a lista de possíveis perguntas na folha de Perguntas do Teste de Turing. Isso pode ser copiado à mão, distribuído ou colocado em um projetor.

Peça que eles escolham qual pergunta eles gostariam de fazer primeiro. Depois que uma pergunta for escolhida, peça que expliquem por que acham que será uma boa pergunta para distinguir o computador do humano. Esse raciocínio é a parte mais importante do exercício, porque forçará os alunos a pensarem sobre o que uma pessoa inteligente poderia responder e um computador não.

Gina e George então retransmitem a pergunta e retornam com uma resposta. A turma deve discutir qual resposta provavelmente é do computador.

Repita isso para algumas perguntas, de preferência até que a classe tenha certeza de que descobriu quem é o computador. Se eles descobrirem quem é o computador rapidamente, o jogo poderá continuar com Gina e George jogando uma moeda para determinar se eles trocarão de papéis, para que a classe não saiba mais qual é o papel dos dois.

As respostas que Connie está lendo não são diferentes das que alguns programas de computador “inteligentes” podem gerar. Algumas das respostas provavelmente entregarão o computador rapidamente. Por exemplo, provavelmente ninguém poderia recitar a raiz quadrada de 2 com 20 casas decimais e a maioria das pessoas (incluindo, talvez, os alunos da turma) não seria capaz de responder essa pergunta de maneira alguma. Algumas perguntas revelarão o computador quando suas respostas forem combinadas. Por exemplo, as respostas de “Você gosta de…” parecem plausíveis por si só, mas quando você encontra mais de uma torna-se evidente que uma fórmula básica está sendo usada para gerar as respostas das perguntas. Algumas das respostas indicam que a pergunta foi mal interpretada, no entanto a turma poderia entender que a pessoa poderia ter cometido o erro.

Muitas das respostas são muito brandas, mas seguras, e uma pergunta subsequente provavelmente revelaria que o computador não realmente entende realmente do assunto. Responder “não sei” é razoavelmente seguro para o computador e pode até parecer mais humano - podemos esperar que um aluno responda “não sei” à algumas perguntas também, como a solicitação para a raiz quadrada de dois. No entanto, se um computador der essa resposta frequentemente, ou para uma pergunta muito simples, isso revelaria sua identidade.

Como o objetivo do computador é fazer com que os questionadores pensem que eles estão lidando com uma pessoa, algumas das respostas são deliberadamente enganosas - como respostas atrasadas e incorretas para um problema aritmético. As perguntas e respostas devem fornecer bastante base para discussão.

Variações e extensões

O jogo pode ser jogado com apenas três pessoas se Gina também levar o papel de George e Connie. Gina leva a pergunta a Herb, anota sua resposta e também anota a resposta da Folha de Respostas do Teste de Turing. Ela retorna as duas respostas, usando as letras A e B para identificar de quem a resposta veio.

Para analisar se um computador poderia imitar um ser humano no interrogatório, discuta com a sala quais conhecimentos seriam necessários para responder a cada uma das perguntas do Teste de Turing. Os alunos podem sugerir outras perguntas que eles gostariam de fazer e deveriam discutir o tipo de resposta esperada. Isso exigirá imaginação, uma vez que é impossível prever como a conversa seria.

A título de ilustração, aqui estão dois exemplos de conversas. O primeiro ilustra perguntas que um computador pode responder corretamente, enquanto o segundo mostra o quão ampla a discussão pode se tornar e demonstra o tipo de conhecimento amplo que um computador pode precisar.

Pergunta: Por favor, escreva-me um soneto sobre a Ponte do Forth.

Resposta: Não conte comigo para isso. Eu nunca poderia escrever poesia.

Pergunta: Some 34957 e 70764.

Resposta: pausa por cerca de 30 segundos … 105621.

Pergunta: Você joga xadrez?

Resposta: Sim.

Pergunta: Meu rei está na posição K1 e não tenho outras peças. Você tem apenas seu rei na posição K6 e uma torre na posição R1. Sua vez.

Resposta: após uma pausa de cerca de 15 segundos … Torre para R8, xeque-mate.

Existe um sistema chamado “Eliza” amplamente disponível na Web (é um tipo de “chatbot”, sistema com o qual você pode digitar conversas). Eliza simula uma sessão com um psicoterapeuta e pode gerar uma conversa notavelmente inteligente usando algumas regras simples. Algumas sessões com Eliza são discutidas abaixo. Os alunos podem experimentar Eliza, ou outros chatbots, no entanto esteja avisado que alguns foram treinados usando linguagem e assuntos que podem não ser apropriados para os alunos em nível escolar.

Pergunta: Na primeira linha do soneto, onde se lê “Devo comparar-te com um dia de verão”, não seria “um dia de primavera” tão bom ou melhor?

Resposta: Não teria a métrica correta.

Pergunta: E “um dia de inverno”? Teria a métrica apropriada.

Resposta: Sim, mas ninguém quer ser comparado a um dia de inverno.

Pergunta: Você diria que o Sr. Pickwick te lembra o Natal?

Resposta: De certa forma.

Pergunta: No entanto, o Natal é um dia de inverno e acho que Pickwick não se importaria com a comparação.

Resposta: Acho que você não está falando sério. Um dia de inverno significa somente um dia típico de inverno, e não um dia especial como o Natal.

Folhas de Atividades e Materiais Adicionais

Você também pode baixar todas as folhas de atividade e materiais adicionais em formato editável aqui.

Do que se trata tudo isso?

Durante séculos, os filósofos discutiram sobre a possibilidade de uma máquina simular a inteligência humana e, inversamente, se o cérebro humano não é mais do que uma máquina executando um programa de computador glorificado. Esta questão dividiu acentuadamente as pessoas. Alguns acham a ideia absurda, insana ou até mesmo blasfema, enquanto outros acreditam que a inteligência artificial é inevitável e que, eventualmente, desenvolveremos máquinas que são tão inteligentes quanto nós. (Como inúmeros autores de ficção científica apontaram, se as máquinas eventualmente superarem nossa própria inteligência, elas mesmas serão capazes de construir máquinas ainda mais inteligentes.) Os pesquisadores de Inteligência Artificial (IA) foram criticados por usar seus objetivos elevados como um meio de atrair financiamento para pesquisas de governos que procuram construir máquinas de guerra autônomas, enquanto os próprios pesquisadores censuram os protestos como uma reação ludita e apontam para os benefícios para a sociedade se houvesse um pouco mais de inteligência por aí. Uma visão mais equilibrada é a de que a inteligência artificial não é absurda nem inevitável: embora nenhum programa de computador atual apresente “inteligência” em um sentido amplo, saber se são capazes disso é uma questão experimental e ainda não foi respondida de qualquer maneira.

O debate sobre IA depende da definição de inteligência. Muitas definições foram propostas e debatidas. Uma abordagem interessante para o estabelecimento da inteligência foi proposta no final da década de 1940 por Alan Turing, um eminente matemático britânico, contra-espião de guerra e corredor de longa distância, como uma espécie de “experimento mental”. A abordagem de Turing era operacional - em vez de definir inteligência, ele descreveu uma situação em que um computador poderia demonstrá-la. Seu cenário era semelhante à atividade descrita acima, a essência era ter um interrogador interagindo com uma pessoa e um computador por meio de um link de teletipografia (a tecnologia mais recente da década de 1940!). Se o interrogador não conseguisse distinguir um do outro seguramente, o computador teria passado no teste de inteligência de Turing. O uso do teletipo evitou que o computador fosse entregue por características físicas ou o tom de voz. Pode-se imaginar estender o exercício para que a máquina tivesse que imitar uma pessoa em aparência, sons, toque e talvez até no cheiro também - mas esses atributos físicos parecem pouco relevantes para a inteligência.

O teste original de Turing era um pouco diferente do nosso. Ele propôs, como exercício preliminar, um cenário em que um homem e uma mulher estavam sendo interrogados, e o interrogador deveria determinar seus sexos. O objetivo do homem era convencer o interrogador de que ele era a mulher, e o da mulher era convencer o interrogador de que ela era ela mesma. Então Turing imaginou - pois isso foi proposto apenas como um experimento mental - um computador substituindo uma das partes para ver se ele poderia ser tão bem-sucedido nesse “jogo de imitação” quanto uma pessoa. Alteramos a configuração dessa atividade em sala de aula porque as perguntas que os alunos poderiam fazer para determinar o sexo provavelmente não seriam apropriadas e, além disso, o exercício promove os esteriótipos sexuais - sem mencionar decepção.

Imitar a inteligência é um trabalho difícil. Se os papéis fossem invertidos e uma pessoa estivesse tentando se passar por um computador, certamente não seria capaz de fazê-lo: seriam entregues por sua resposta lenta (e provavelmente imprecisa) a perguntas como “Quanto é 123456 × 789012?”.

No entanto, é surpreendentemente fácil para um computador adquirir uma capacidade de conversação mais superficial. Um famoso programa desenvolvido no início dos anos 60, Eliza (mencionado anteriormente), simula um psicoterapeuta não-diretivo em um diálogo com o usuário. Abaixo está um exemplo de conversa com este sistema.

Pessoa: Todos os homens são iguais.

Computador: De quê maneira?

Pessoa: Eles sempre estão nos incomodando com uma coisa ou outra.

Computador: Você consegue pensar em um exemplo específico?

Pessoa: Bem, meu namorado me fez vir aqui.

Computador: Seu namorado fez você vir aqui.

Pessoa: Ele diz que estou deprimida a maior parte do tempo.

Computador: Lamento saber que você está deprimida.

Pessoa: É verdade. Eu estou infeliz.

Computador: Você acha que vir aqui ajudará você a não ser infeliz?

Pessoa: Preciso de ajuda, isso parece certo.

Computador: O que significaria para você se você recebesse alguma ajuda?

Pessoa: Talvez eu possa aprender a me dar bem com a minha mãe.

Computador: Conte-me mais sobre sua família.

…

Computador: O que mais vem à sua mente quando você pensa em seu pai?

Pessoa: Valentões.

Computador: Isso tem algo a ver com o fato de seu namorado ter feito você vir aqui?…

Algo que se aproxima de uma conversa natural é alcançado por recursos como:

Gerar respostas comuns (você pode pensar em um exemplo específico em resposta a algo começado com “Eles sempre …”; “Lamento saber que…” em resposta a “Ele diz …”);

Ecoar as declarações do usuário (por exemplo, “Seu namorado fez você vir aqui” em resposta a “Meu namorado me fez vir aqui”);

Reconhecer palavras-chave (“Conte-me mais sobre sua família” em resposta a “…mãe…”);

Algumas frases comuns para terapeutas (“o que significaria para você se …”);

Questões abordadas em partes anteriores da conversa (“Isso tem algo a ver com o fato de que …”).

Obviamente, isso não significa que o computador foi aprovado no teste de Turing, porque a pessoa não está fazendo perguntas com o objetivo de identificar se o entrevistado é uma máquina ou não: se estivesse, não demoraria muito para que tudo fosse revelado.

Um incidente amplamente contado, que pode ser apócrifo, mas agora passou para o folclore da inteligência artificial, ocorreu quando um vice-presidente de vendas de computadores supostamente se deparou com um terminal que normalmente estava diretamente conectado à casa de uma pessoa em particular, mas nessa ocasião estava executando o programa do “psicoterapeuta”. Essa conversa mostra o que aconteceu. Embora o vice-presidente tenha sido evidentemente envolvido, é claro que a situação o predispunha a acreditar que estava conversando com uma pessoa. Se ele suspeitasse o contrário, logo descobriria!

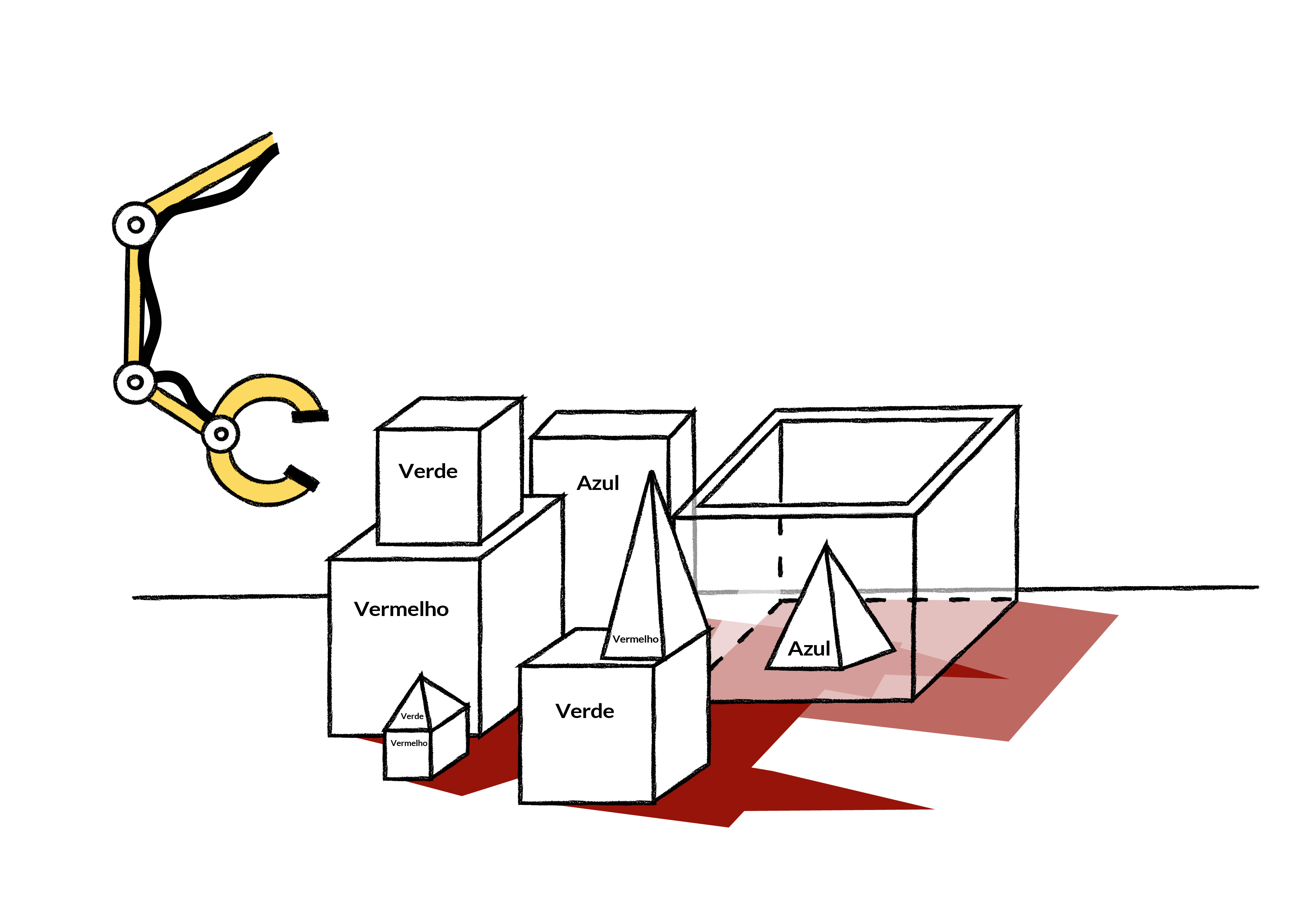

Outro sistema que parece capaz de manter conversas inteligentes é um programa chamado “SHRDLU”, desenvolvido no final dos anos 60 e recebia instruções para manipular os blocos em cima de uma mesa. Na verdade, os blocos e a mesa foram simulados e apresentados na forma de uma imagem na tela de um computador, embora não fosse muito difícil fazer as coisas funcionarem com um robô real (pelo menos em princípio). A imagem mostra o micro-mundo do robô.

SHRDLU pôde manter conversas surpreendentemente fluentes, como mostrado no diálogo abaixo. Entre outras coisas, o diálogo ilustra como ele pode obedecer a ordens, instruções ambíguas, entender os referentes dos pronomes e novos termos (“torre”).

Pessoa: Pegue o bloco grande e vermelho.

Robô: OK.

O sistema responde “OK” quando executa um comando. Para pegar o bloco vermelho, ele precisou abrir o caminho encontrando um espaço para o bloco verde e afastando-o.

Pessoa: Segure a pirâmide.

Robô: Não sei qual pirâmide você quer dizer.

Existem três pirâmides em cena, então o programa não faz nada.

Pessoa: Encontre um bloco mais alto que o que você está segurando e coloque-o na caixa.

O sistema precisa descobrir o que se entende por “o que” e “o”, além de usar a dedução para decidir qual bloco está segurando.

Robô: Por “o”, eu suponho que você quer dizer o bloco que é mais alto que o que eu estou segurando.

Este aviso foi dado apenas para fins informativos.

Robô: OK.

A mão tem que pousar o bloco vermelho para pegar o azul mais alto.

Pessoa: O que tem na caixa?

Robô: A pirâmide azul e o bloco azul.

Pessoa: Qual é o suporte da pirâmide?

Anteriormente, o sistema respondeu à “pirâmide” dizendo “Não sei qual pirâmide você quer dizer”. Agora, sabe que nos referimos a que acabamos de mencionar.

Robô: A caixa.

Pessoa: Faça uma torre …

Robô: Desculpe, não conheço a palavra “torre”.

O sistema interrompe imediatamente quando vê uma palavra que não consegue descobrir.

Pessoa: Uma “torre” é uma pilha que contém dois cubos verdes e uma pirâmide.

As aspas indicam que estamos definindo uma nova palavra.

Robô: Eu entendo.

Pessoa: Há torres agora?

Robô: Não.

A nova definição é usada como uma descrição para reconhecer torres.

Pessoa: Construa uma.

Robô: OK.

A descrição dada na definição é suficiente para deduzir um plano para a construção de novos objetos, além de reconhecê-los. A palavra “uma” significa “uma torre”, e o plano é realizado.

No entanto, o sistema é muito frágil e a ilusão que cria é facilmente destruída.

Aqui está uma continuação da conversa - que não foi realmente gerada pelo programa, mas certamente poderia ter sido. Embora tenha sido possível definir o novo termo “torre” na última conversa, apenas um tipo muito limitado de termos pode ser descrito porque o robô possui uma “inteligência” extremamente restrita.

Pessoa: Eu troco uma pistola de água pelo bloco grande vermelho.

Robô: Desculpe, não conheço a palavra “troco”.

Pessoa: “Trocar” significa permutar livremente uma propriedade.

Robô: Desculpe, não conheço a palavra “livremente”.

Pessoa: Um ato “livre” é feito de boa vontade, sem ser forçado.

Robô: Desculpe, não sei a palavra “ato”.

Pessoa: “Atos” são o que as pessoas fazem de propósito, e não por acidente.

Robô: Desculpe, não conheço a palavra “pessoas”.

Pessoa: Desculpe, pensei que você fosse mais esperto do que é.

Robô: Desculpe, não conheço a palavra “desculpe”.

Por fim, tem que admitir que ele nem sequer entender as palavras que ele mesmo usa (“Desculpe, não conheço a palavra”desculpe")!

Agora considere uma continuação alternativa e completamente imaginária da conversa, que talvez tenha sido gerada por um aluno.

Embora pequeno, esse fragmento demonstra uma riqueza de conhecimento do mundo.

Pessoa: Eu troco uma pistola de água pelo bloco grande vermelho.

Robô: Eu já tenho uma pistola de água, mas vou lhe dar dois blocos e uma pirâmide pelo seu sapo velho e viscoso.

O “robô” considera que uma pistola de água é menos valiosa se você já tiver uma;

Além disso, espera que a pessoa considere isso também, pois não se preocupa em explicar que esse é um motivo para recusar a oferta;

Ainda assim, ele vê que a pessoa quer o bloco suficientemente para se separar de algo importante;

Além disso, considera que, diferentemente das pistolas de água, os blocos são valiosos em quantidade;

Ele tenta amolecer a pessoa humilhando o sapo;

Implica que está preparado para pechinchar.

Certamente esse grau de astúcia está além dos computadores de hoje!

A história abaixo foi gerada por outro programa de computador (no final dos anos 80). Embora seja imediatamente revelado que foi gerado por um computador por sua pobreza e discrepância, não é difícil imaginar como ele poderia ser melhorado, adicionando todo tipo de detalhe extra. O interessante não são os aspectos superficiais da história, mas a trama que ela representa. Embora esteja muito distante de qualquer enredo gerado por humanos, ele parece capturar alguns elementos humanos de conflito. Atualmente, existem vários sistemas para gerar histórias automaticamente, embora o desafio de avaliá-las seja determinar quanto do material são apenas padrões comuns com as lacunas preenchidas e quanto é um enredo que foi construído criativamente como abaixo.

“Era uma vez uma gaivota ártica chamada Truman. Truman não tinha uma casa. Truman precisava de um ninho. Ele voou para a costa. Truman procurou galhos. Truman não encontrou galhos. Ele voou para a tundra. Ele conheceu um urso polar chamado Horace. Truman perguntou a Horace onde havia galhos. Horace escondeu os galhos. Horace disse a Truman que havia alguns galhos no iceberg. Truman voou para o iceberg. Ele procurou galhos. Ele não encontrou galhos. Horace procurou carne. Ele encontrou carne. Ele comeu Truman. Truman morreu.”

Há uma competição anual pelo prêmio Loebner, na qual os programas de computador competem para passar no Teste de Turing, enganando os juízes e fazendo-os pensar que são humanos. Desde de 2012, nenhum computador ganhou ainda os prêmios de ouro ou prata, que envolvem enganar consistentemente os juízes, mas um prêmio de bronze é concedido a cada ano para o que é considerado mais humano. No primeiro ano da competição (1991), um programa conseguiu ganhar o prêmio de bronze por, entre outros truques, cometer erros de digitação para parecer mais humano!

Não foi criado nenhum sistema de inteligência artificial que chegue perto de passar pelo Teste de Turing completo. Mesmo se alguém o fizesse, muitos filósofos argumentam que o teste não mede realmente o que a maioria das pessoas entende por inteligência. O que ele testa é a equivalência comportamental: ele é projetado para determinar se um determinado programa de computador exibe os sintomas do intelecto, que podem não ser a mesma coisa que genuinamente possuir inteligência. Você pode ser humanamente inteligente sem estar consciente, conhecer a si mesmo, ser capaz de sentir autoconsciência, experimentar amor, estar … vivo?

É provável que o debate sobre IA esteja conosco por muitas outras décadas.